OpenAIがChatGPTを世界中に公開した後、私たちは人々が信じられないほどのテイクを見ました。 一部の人々はチャットボットに目覚めた議題があると主張した。 米国上院議員のChris Murphyは、ChatGPTが高度な化学を「教えた」とツイートしました。 熟練した技術ジャーナリストでさえ チャットボットは彼らと恋に落ちた。 世界は、穴居人が初めて火を見たときに反応したのと同じ方法でAIに反応するようです。 完全に混乱して一貫性のない擁護です。

最新のケースの一つは 60分、CBS日曜日に放映されたAIイノベーションに焦点を当てた新しいエピソードでリングで声を高めました。 このエピソードには、Google CEO Sundar Pichai などのユーザーとのインタビューが含まれ、疑わしい内容が含まれています。 会社の大規模言語モデル(LLM)の1つについての主張。

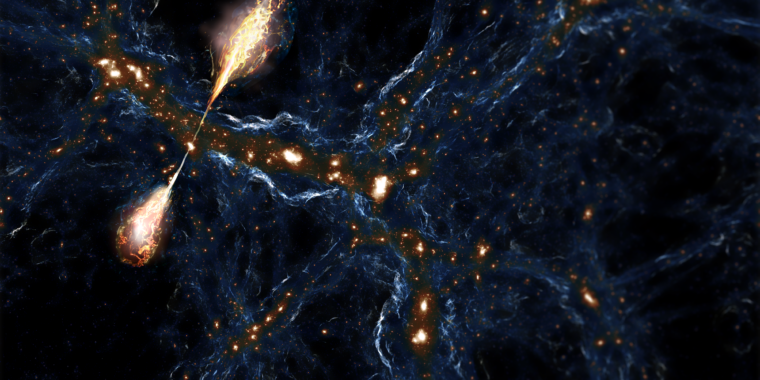

クリップの主題は、モデル開発者が意図しないAIシステムの予期しない副作用を説明する緊急動作に関するものです。 私たちはすでに他の最近のAIプロジェクトで出現する行動を見てきました。 たとえば、研究者は最近、ChatGPTを使用して、先週オンラインで公開された研究で目標と背景を持つ生成デジタルキャラクターを作成しました。 彼らは、システムがあるキャラクターから別のキャラクターに新しい情報を共有し、互いに関係を形成するなど、いくつかの緊急アクションを実行することを観察しました。 これは、作成者が最初にシステムを計画していないことです。

緊急行動は確かにニュースショーで議論する価値があるトピックです。 どこに 60分 ただし、クリップはトランジションを取得します。 Googleのチャットボットがその言語でメッセージを表示した後、以前に知らなかった言語を実際に自分で教えることができたという主張が紹介された時です。 CBSニュース特派員のScott Pelley氏は、Clipで言います。

それは完全なBSでした。 ボットは外国語を学ぶことができなかっただけでなく、「知るように訓練されたことがありません」。 新しいスキルを自分で教えることもありませんでした。 クリップ全体は、AI研究者と専門家がTwitterでニュースプログラムの誤解を招くフレーミングを非難するように刺激しました。

サンタフェ研究所のAI研究者であり教授のMelanie Mitchell氏は、次のように述べています。 ツイートに書いた。

「技術分野で魔法のような考えはやめて! トレーニングデータがベンガル語で汚染されているか、アサム語、オリヤ語、ヒンディー語などのベンガル語と重複する言語で訓練されていない限り、#AIはベンガル語で応答することは不可能です。 M. Alex O. Vasilescu, a MIT 研究者, 他の投稿に追加されました。

言及する価値があります。 60分 セグメントは、彼らが使用したAIが正確に何であるかを言っていませんでした。 しかし、CBSのスポークスマンは、The Daily Beastに、このクリップはBardについての議論ではなく、PaLMという別々のAIプログラムだと述べた。 PaLMの基礎技術は後でBardに組み込まれた。

このセグメントがこれらの専門家にとってとても残念な理由は、生成AIが実際にできる現実を無視して操作するためです。 もともと言語にアクセスできなかった場合、自分で言語を「教える」ことはできません。 それは北京語を自分で教えようとするのと同じですが、誰かが北京語を一度聞いた後に聞いたことがあります。

結局のところ、言語は微妙なニュアンスと規則のために理解し、コミュニケーションするのに膨大なレベルのコンテキストを必要とする非常に複雑です。 最も先進的なLLMであっても、いくつかのプロンプトですべてを解決して学ぶ方法はありません。

PaLMはすでにバングラデシュの主要言語であるベンガル語で教育を受けています。 ATスタートアップ研究所のHuggingFaceの研究者であり、以前GoogleのMargaret Mitchell(関係なし)はこれについて次のように説明しました。 ツイートスレッド 理由に関する論文の作成 60分 間違った。

Mitchellは、2022年のデモで、GoogleはPaLMがベンガル語で通信し、プロンプトに応答できることを示したと指摘しました。 それだけ PaLMの後ろの紙 モデルが実際にベンガル語のアルファベットで約1億9,400万のトークンを使用して言語で訓練されたことをデータシートで明らかにしました。

したがって、単一のプロンプトで魔法のように何も学びませんでした。 すでに言語を知っていました。

GoogleのCEOであるPichaiがインタビューに参加し、これらの主張に反論することなく進行することを許可した理由は明らかではありません。 (Googleはコメントの要求に答えなかった) Twitterでマーガレットミッチェル 提案 その理由は、製品がどのように機能するかを知らない Google リーダーシップと、生成された AI の現在の過大広告に対処するために粗雑なメッセージが伝播されることを許可するためです。

「予想して [Google executives] 文字通り、それがどのように機能するのか理解していません。」 ミッチェル ツイート。 「私が上で書いたのは彼らにニュースです。 そして彼らは理解しないようにインセンティブを受け取ります(そのデータシートに目を閉じてください!)。

ビデオの後半はまた、PichaiとPelleyがBardによって作成された短い話について議論し、問題があると見られます。

実際、これらの製品は魔法ではありません。 彼らは人間ではないので、「人間」になることはできません。 彼らは携帯電話のようなテキスト予測器であり、フレーズの一連の単語の後に最も類似した単語とフレーズを提示するように訓練されました。 彼らがいると言うことは、信じられないほど危険なレベルの権限を彼らに与えることができます。

結局のところ、ユーザーはこれらの生成AIを使用して間違った情報を広めるなどのことを行うことができます。 私たちはすでに人々の姿と彼らの声まで深いフェイクを見ました。

チャットボット自体もバイアスされた結果を生成すると、害を及ぼす可能性があります。 すでに ChatGPT や Bard のようなケースで見ることができます。 幻覚を引き起こし、結果を生み出すこれらのチャットボットの傾向を知ると、疑わしいユーザーに誤った情報を広めることができます。

研究でもこれを証明します。 最近の研究 に公開 科学レポート 道徳的な質問に対する人間の反応が ChatGPT の主張によって容易に揺れることがわかった。

に対する誤解を招く主張 60分 私たちが最も必要とする時期にデジタル文解力に対するより大きな要求の症状に過ぎません。 多くのAI専門家は、今がこれまで以上に正確にAIができることとできないことを人々が知っておくべき時だと言います。 ボットに関するこれらの基本的な事実は、より多くの国民に効果的に伝える必要があります。

これは、最大のプラットフォームと最大の声を持つ人々(メディア、政治家、および巨大な技術管理者)が、AIに関してより安全で教育を受けた未来を確保するための最大の責任を負うことを意味します。 さもなければ、前述の穴居人のように火の魔法で遊んで、その過程でやけどをすることもあります。

+ There are no comments

Add yours